AI is nu al overal - en dat betekent wat voor onze planeet

Zelfs als je kunstmatige intelligentie wilt vermijden, lukt dat waarschijnlijk niet. En de onzichtbare energiekosten daarvan lopen snel op.

Published on May 23, 2025

Medeoprichter van Media52 en hoogleraar Journalistiek, bouwt aan IO+, events en Laio, met focus op commerciële kansen—en blijft schrijven voor IO+.

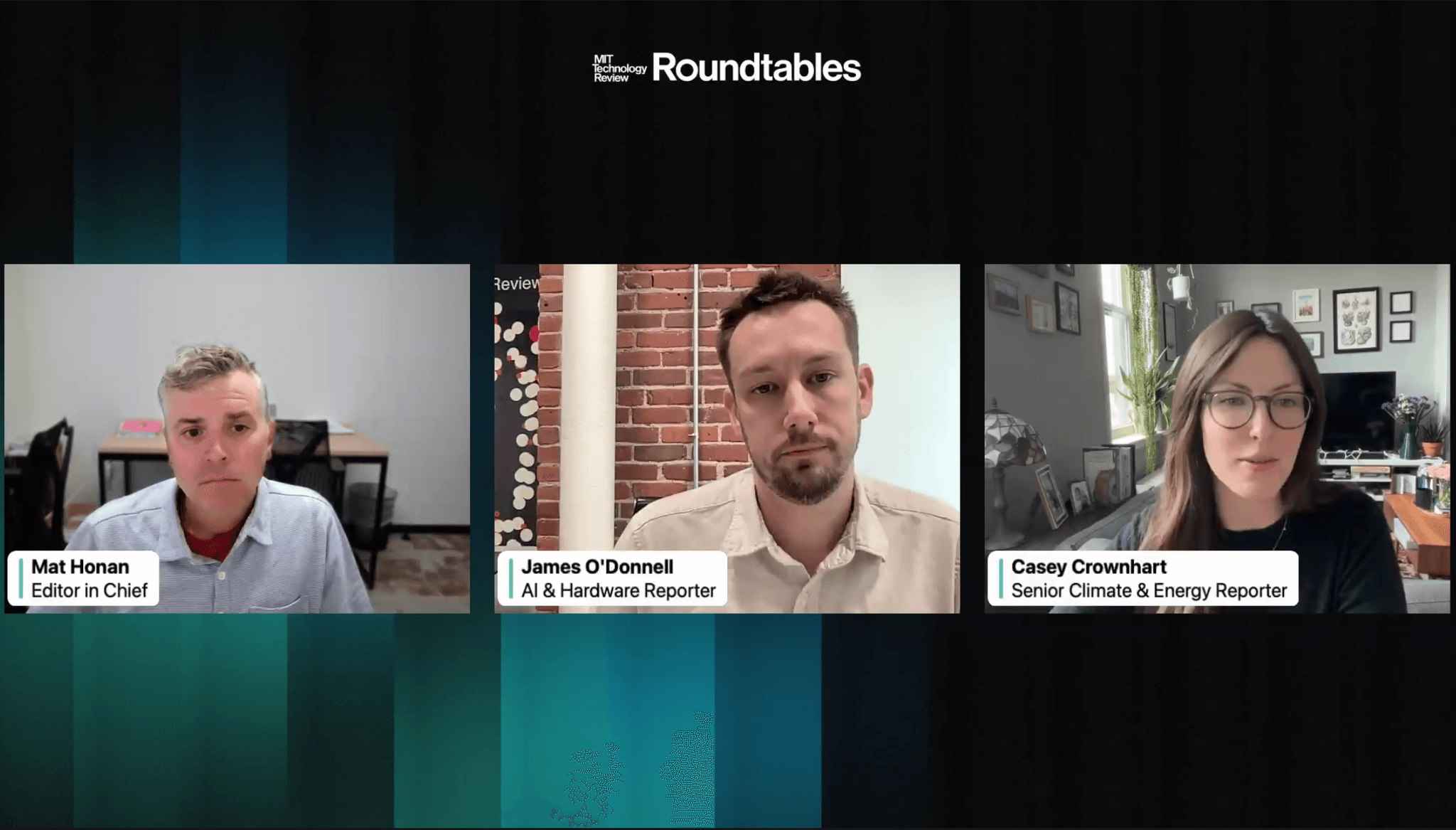

Terwijl je dit leest, speelt kunstmatige intelligentie al een rol - of je dat nu wilde of niet. Dat is de centrale boodschap van een recente rondetafeldiscussie van MIT Technology Review, waarin hoofdredacteur Mat Honan in gesprek ging met journalisten James O’Donnell en Casey Crownhart over de groeiende impact van AI op ons energiesysteem — en hoe moeilijk het wordt om daar nog aan te ontsnappen. Het gesprek maakte deel uit van de serie van Technology Review over AI en onze energietoekomst.

“Mensen zeggen: ‘Dan gebruiken we het gewoon niet’,” zei O’Donnell. “Maar voor de meesten van ons is dat straks helemaal geen optie meer.” AI is inmiddels ingebouwd in bijna elke dienst, van klantenservicebots tot productiviteitstools en fitnessapps. Of je nu wilt of niet: AI maakt al deel uit van je dagelijkse leven.

Watt doet ertoe in AI

"Watt Matters in AI" is een initiatief van Mission 10-X, in samenwerking met de Rijksuniversiteit Groningen, Universiteit Twente, Technische Universiteit Eindhoven, Radboud Universiteit en Convention Bureau Brainport Eindhoven. IO+ is verantwoordelijk voor marketing, communicatie en de organisatie van de conferentie.

Meer informatie op de website van de conferentie.

Van trainen naar gebruiken: de verschuiving in energieverbruik

De meeste aandacht rond het energieverbruik van AI gaat tot nu toe uit naar de trainingsfase: het moment waarop een model zoals ChatGPT gevoed wordt met enorme hoeveelheden data. Dat proces is intensief en kost weken of zelfs maanden aan rekentijd in grote datacenters.

Maar volgens O’Donnell en Crownhart is het échte energieverhaal inmiddels verschoven naar de zogeheten inference-fase — het moment waarop een model vragen beantwoordt van gebruikers.

“Het overgrote deel van het energieverbruik zit nu in het gebruik van AI, niet meer in het trainen,” aldus O’Donnell. “Onderzoekers vertelden ons dat inmiddels 80 tot 90% van de energie naar inference gaat.”

En inference stopt nooit. “Het draait 24/7,” voegde Crownhart toe. “Je kunt het niet slim plannen zoals bij training, om bijvoorbeeld zonuren te benutten. Het gebeurt gewoon, de hele dag door.”

From the Roundtable, MIT Technology Review

Kleine vragen, grote voetafdrukken

Hoeveel energie kost een AI-vraag eigenlijk? Dat hangt sterk af van wat je vraagt.

Op basis van metingen met open-source modellen (grote techbedrijven gaven geen inzage), bleek dat een typische tekstprompt ongeveer evenveel stroom gebruikt als het acht seconden aanzetten van een magnetron. Niet veel — totdat je bedenkt dat miljoenen mensen dat dagelijks doen.

Bij beeldgeneratie bleek het energieverbruik vaak zelfs iets lager. Maar bij video verandert alles. “Een AI-video van vijf seconden kan 700 keer meer energie kosten dan een afbeelding,” aldus O’Donnell. “Dat is enorm.”

Watt Matters in AI

Watt Matters in AI is een conferentie die zich richt op het verkennen van het potentieel van AI met aanzienlijk verbeterde energie-efficiëntie. In de aanloop naar de conferentie publiceert IO+ een serie artikelen die de huidige situatie en mogelijke oplossingen beschrijven. Tickets voor de conferentie zijn te vinden op wattmattersinai.eu.

Waar je bent, maakt uit

Een andere belangrijke factor is waar de AI jouw vraag verwerkt. Dat bepaalt namelijk hoeveel CO₂ er vrijkomt.

“Een datacenter op kolenstroom in West Virginia veroorzaakt veel meer emissies dan een zonnepark in Californië,” legde Crownhart uit. “Zelfs als beide dezelfde hoeveelheid stroom gebruiken.”

De CO₂-uitstoot per kWh stroom — ook wel de ‘koolstofintensiteit’ — verschilt per regio en per moment. Maar gebruikers weten zelden waar hun prompt wordt verwerkt, omdat techbedrijven die informatie geheim houden.

Een minder bekend, maar alarmerend aspect is bovendien het enorme waterverbruik van AI. Datacenters gebruiken miljoenen liters schoon drinkwater per dag om oververhitte servers te koelen — vaak in gebieden die al kampen met waterschaarste.

En nee, dat water wordt lang niet altijd hergebruikt. Veel ervan verdampt direct.

Wat kun jij doen?

Moet je je schuldig voelen als je ChatGPT een haiku laat schrijven?

Niet per se. Individuele keuzes kunnen wel helpen , zoals het vermijden van video’s of het kort houden van prompts, maar de echte verantwoordelijkheid ligt elders.

“Geen enkel groot AI-bedrijf was bereid om openheid te geven over het energieverbruik,” benadrukte Honan. “En toch vragen ze ons om publieke infrastructuur te gebruiken om hun modellen te draaien. Dat is problematisch.”

De oproep van de journalisten: leg druk op bedrijven om transparanter te zijn en geef beleidsmakers de informatie die nodig is om AI te verduurzamen.

Een beslissend moment

Twee inzichten springen eruit. Ten eerste: dit is geen gewone digitale groei — AI betekent een echte breuk met het verleden. “Van 2005 tot 2017 bleef het stroomverbruik van datacenters vrijwel gelijk,” zei O’Donnell. “Pas sinds AI is dat explosief gestegen.”

Ten tweede: de toekomst ligt nog open. “Iedereen wil één getal voor het energieverbruik van AI,” zei Crownhart. “Maar dat bestaat niet — het hangt af van het model, de vraag, de locatie en de timing. Dat betekent dat we nu nog kunnen sturen.”

Terwijl AI onvermijdelijk wordt, bepaalt wat we nú doen — qua infrastructuur, transparantie en regelgeving — of deze technologie ons helpt of juist extra schade aanricht.